人工知能技術のユニバーサルサービス化に向けて(下)

-クラウドAIサービスで広がるAI技術-

デジタルコグニティブサイエンスセンター

R&Dグループ

コンサルタント 稲村 博央

AI技術開発の難しさと人材不足

ハードウエア・ソフトウエア面でAI開発のより良い環境が整ってきたとは言え、ほとんど知識を持たない者がすぐにAI技術を導入・利用できるかというと、非常に難しい。

ディープラーニングを例として、その難しさを説明しよう。まず必要なデータおよびデータ項目の整備、データクレンジング、ニューラルネットの設計、アルゴリズム上のさまざまなパラメータチューニングなどが必要となる。この中でもニューラルネットの設計とパラメータチューニングは非常に難しい。

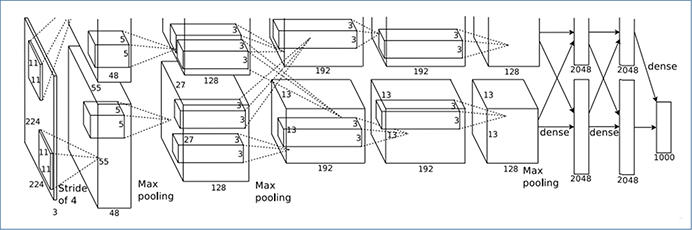

例えば、ILSVRC2012※1で2位以下に10%以上の精度の差をつけて優勝し、現在のAIブームの火付け役となったAlexNetと呼ばれるDNN(ディープニューラルネットワーク)の全体像を図表1にあげる。これはGoogleエンジニアリングフェロー兼トロント大学教授のGeoffrey Hinton氏が考案したものだ。

図表1:ILSVRC2012優勝のDNN「AlexNet」

(出所)Alex Krizhevsky, Ilya Sutskever, Geoffrey E. Hinton, “ImageNet Classification with Deep Convolutional Neural Networks”, NIPS2012.

図表1を見て、どのような事が行われ、どのようなチューニングが必要になりそうか想像できる人が果たしてどれだけいるだろうか。

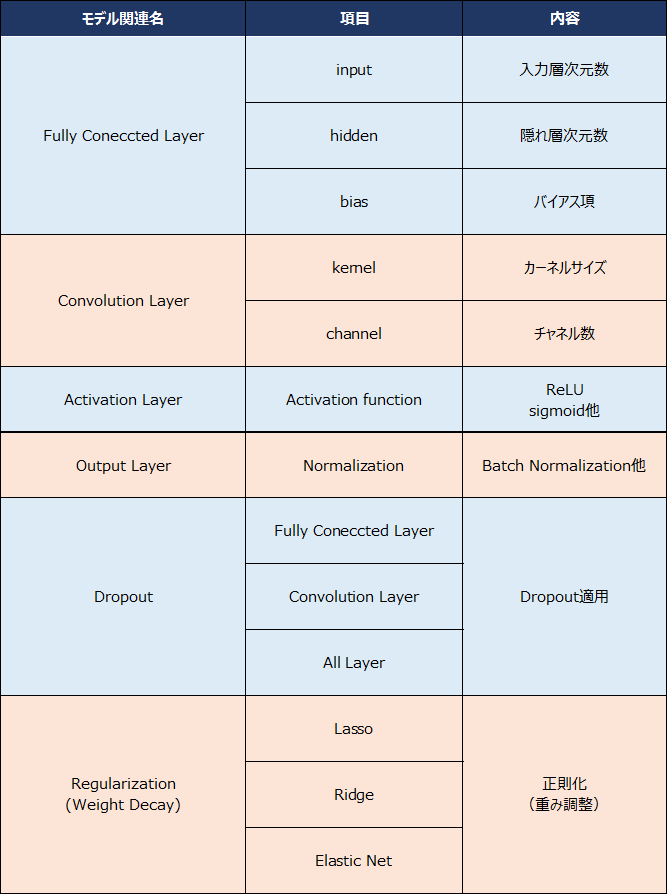

このAlexNetはCNN※2を利用した8層からのDNNとなっており、現在となってはかなりシンプルな構造と言える※3。それでも多くのパラメータチューニングの上に成り立っており、単純なCNN部分を実装するだけでも以下のようなパラメータ調整が必要となる(図表2)。

図表2:CNNで調整が必要となるパラメータの一例

(出所)浅川伸一著「Pythonで体験する深層学習」を参考にNTTデータ経営研究所にて作成

これらのパラメータに加え、さらに学習アルゴリズム、バッチサイズ、学習率、エポックなど多くの選択や調整が必要となる。そして何度もパラメータチューニングを繰り返し、時には再設計からやり直すなどして、最適な学習モデルを探すことになる。

単純なCNN部分の実装だけでもその複雑さ、難しさが読み取れる。実際にはAutoencoder/Denoising Autoencoder※4などを利用した特徴抽出・事前学習も含め、より深く複雑なニューラルネットを設計・構築する必要がある。これは各種ディープラーニングフレームワーク等を活用したとしても、現状では避けて通れない道となっている。

現在、各種ディープラーニングフレームワーク上でAlexNetが実装されており、この学習済みモデルをそのまま利用することや、Transfer Learning(転移学習)に用いることもできる。しかし、それでも一定以上の数学的な知識とITスキルが前提になってしまうのは言うまでもない。

また、ディープラーニング以外の各種機械学習手法についても、さまざまなパラメータの調整や前段階の準備としてデータクレンジングなどが求められる。そのため、ここでも、依然として一定以上の数学と幅広いITスキルが必要となる。

今現在もデータサイエンス・AI分野の専門人材がさまざまな企業で求められているゆえんである。

- ※1 ImageNet Large Scale Visual Recognition Challengeという2010年から毎年開催されている大規模画像認識コンテスト。(http://www.image-net.org/challenges/LSVRC/)

- ※2 Convolutional Neural Networks の略で、畳み込みニューラルネットワークと呼ばれる人間の視覚野を参考に考案された手法。画像認識分野において高い精度を発揮している。

- ※3 ILSVRC2015で優勝したMicrosoft Researchの「ResNet」は152層からなるDNNとなっている。(https://arxiv.org/abs/1512.03385)

- ※4 2006年にGeoffrey HintonがAutoencoderを考案し、その後Pascal VincentとYoshua BengioがDenoising Autoencoder等へ発展させた。日本語では自己符号化器と呼ばれる。(https://www.cs.toronto.edu/~hinton/science.pdf)

AI技術の普及を加速するクラウドAIサービス

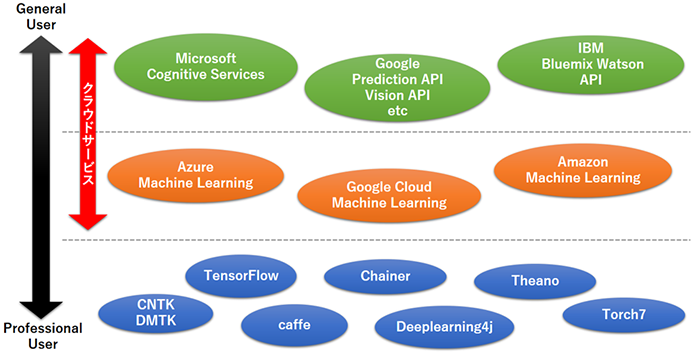

このような中、現在、AI技術をより簡単に利用できるサービスとして、さまざまなクラウドAIサービスが登場してきている(図表3)。代表的なサービスとしてはMicrosoftのAzure Machine LearningやAmazon Machine Learning、2016年9月に公開されたばかりのGoogle Cloud Machine Learning※5がある。それぞれ、GUIベースのIDE環境※6としてデザインされており、開発がしやすく、自社システムや他サービスとの接続なども容易である。

図表3:さまざまなAI技術・サービス

(出所)各AI技術・サービスの公式ホームページを参考にNTTデータ経営研究所にて作成

一方で、Microsoft Cognitive ServicesやGoogle Cloud Vision APIのようにAPIベースで高度なサービス提供が行われているものがある。これらはMicrosoftやGoogleがすでに学習済みのモデルを提供しているものであり、APIを利用するだけでMicrosoftやGoogleのAI技術をそのまま利用できるのである。

一例として、Microsoft Cognitive ServicesのAPIのみを利用した視覚障害者向けのサービスデモ(再生時間2分強)が公開されているのでそれを参考にしてもらいたい(映像1)。

映像1:Microsoft Cognitive Services: Introducing the Seeing AI project

(出所)Youtube Microsoft official channel(https://www.youtube.com/watch?v=R2mC-NUAmMk)

この動画では、視覚障害者向けにウェアラブルグラス、スマートフォンを利用し、人間の目の代わりを実現している。ウェアラブルグラス経由で取得した映像や画像から、状況、感情、テキストまでさまざまなものをクラウド上のAIが認識・理解している。驚くべきことは、このデモのための高度なAIソフトウエア開発や特殊な機器は一切使われておらず、一般に利用できるCognitive Services APIとスマートフォン及びBluetooth通信可能な市販のウェアラブルグラスのみでサービスを実現している点である。現在のAIブーム以前であれば、実証実験であったとしても、このようなサービスを実現するためにどれだけの投資と環境整備が必要であったかは想像に難くない。

Google Cloud、IBM Bluemix Watsonでも同様の高度なクラウドAIサービスが提供されているが、面白いデモとしてGoogle Cloud Vision Explorerを紹介しよう(図表4)。

図表4:Google Cloud Vision Explorer実際の画面

(出所)Reactive Inc.およびGoogle Inc.のGoogle Cloud Vision Explorer(http://vision-explorer.reactive.ai/)

注:最新版のGoogle chromeでのみ動作保証

これはWikimedia Commons※6上にある約8万点の画像データをReactive社がGoogle Cloud Vision APIと独自のクラスタリング手法を適用し、可視化したもので、2016年3月のGCP NEXTでGoogleのJeff Dean氏によって発表された※7。Google Cloud Vision APIで認識した画像を特徴空間に表示し、その中を探索することができる。

例えば、図表4の右の画像のように猫が集まる地点で、画像を選択するとGoogle Cloud Vision APIの認識結果が表示される。ただ「猫」と認識されるわけではなく、この場合、「猫」98%、「ペット」98%、「哺乳類」95%、「動物」93%、ターキッシュアンゴラ89%というように、飼われているペットであるか、猫の種類は何かという部分まで認識できている。Reactive社はGoogleからの依頼を受け、このGoogle Cloud Vision Explorer を2週間で作り上げたという。

クラウドリソースというイメージが強いAmazonもAlexa※8によるクラウドAIサービスに本腰を入れている。Amazonの特徴は、スマート家電のような設置型機器を通じたクラウドAIの普及を進めていることだろう。

例えばAmazon はスマートスピーカーとして有名なAmazon Echoやテレビへ設置するFire TV Stick with Alexa Voice Remote※9などを通じ、Alexaの拡大を狙っている。特に、Amazon Echoは2015年の米国のスピーカー販売シェアの25%強を獲得しており、一強状態となっている。2016年10月にはFord社の一部自動車でAlexaの利用が可能になると発表された。Amazonは自動車から家電まで、Alexaによるスマート機器ベースのサービス環境の構築を目指していると考えられる。

Googleが2016年9月にクラウドサービスを再編し※10、あらためてサービス提供を開始したのも、MicrosoftやAmazon、IBMに対し、本格的に攻勢をかけるためのものと考えられる。

国内企業も東芝がクラウドAIサービスとして「RECAIUS」による音声・映像・知識探索などのサービス提供を開始、富士通は「Human Centric AI Zinrai」としてAIサービスをクラウド・オンプレミスの両方で利用ができるように進めている。NTTコミュニケーションズも綜合警備保障(ALSOK)と連携し、AIによる不審者検知を始めとした映像解析プラットフォームサービスの提供を検討していることを発表した。NTTもNTTグループ6社によるAI技術「corevo」を用いたクラウドAI環境構築のための実証実験を開始※11、クラウドAIサービスの本格的な提供を視野に入れている。

近い将来、独自の高度なAI技術を軸に事業を推進する企業と、さまざまなクラウドAIサービスを組み合わせ、AIインテグレーションとして展開する企業に大きく分かれるものと考えられる。いずれにせよ、AI技術はよりコモディティ化し、社会のさまざまなシーンで利用が進むことになるのは間違いない。

- ※5 Google’s Cloud Machine Learning service is now in public beta.(https://techcrunch.com/2016/09/29/googles-cloud-machine-learning-service-is-now-in-public-beta/)

- ※6 誰でも自由に利用できる画像・音声・動画、その他あらゆる情報を包括して供給すること目的としたwikipediaプロジェクトの姉妹プロジェクトでウィキメディア財団により運営されている。

- ※7 Explore the Galaxy of images with Cloud Vision API.(https://cloud.google.com/blog/big-data/2016/05/explore-the-galaxy-of-images-with-cloud-vision-api)

- ※8 Amazonの展開するクラウドAIベースの音声アシスタント。

- ※9 Alexaに対応したテレビのHDMIポートに差し込んで利用するスティック型映像配信端末。

- ※10 All together now. Introducing G Suite.(https://cloud.googleblog.com/2016/09/all-together-now-introducing-G-Suite.html)

- ※11 NTTグループのAI技術「corevo」を実装した共通基盤にてデバイス連携サービスの合同実証実験を開始。(http://www.ntt.co.jp/news2016/1607/160725a.html)

おわりに

本稿では、AI技術の開発の難しさを起点に、クラウドAIサービスの発展によるAI技術のトレンドと将来の展望について述べた。

将来、より優れたAI開発環境・導入サービスが整ってきたとしても、注意しなければいけない大前提が一つある。

それは、そもそも目指す目的をAI技術で達成できるのか、解決したい課題をAI技術で解決できるのか、そしてどんなAIで目的達成、課題解決を行うのかについて、しっかり評価・検討を行い、明らかにしておかなければならないということだ。

この大前提を無視してやみくもにAIを利用しようとすると、AI技術を利用したということ以外に何も残らず、コストをかけた挙げ句、目的達成・課題解決への活用には程遠い「ジャンクAI」が生まれてしまう。

今後、IoT環境の普及とAIの活用による環境知能(Ambient Intelligence)のような形を合わせ、AI技術は社会の隅々にまで浸透していくだろう。このように誰でもがAIを利用し、その恩恵にあずかることができる「AI技術のユニバーサルサービス化」が進むにつれ、QOL(Quality of Life)の高い社会が実現されていくと考えられる。

その実現に向け、企業はAIをどう活用し、どのようなサービスを顧客に提供するのかが問われる。その時にカギを握るのは、専門性を持ちつつも、よりユーザ目線でAI技術の利活用を考え、製品やサービスをデザインできる人材の育成である。

AIを単なるコスト削減手段としてマイナス思考的に捉えるのではなく、「人間と共存することで、新たな付加価値の創出と提供を可能にするもの」として、プラス思考的にデザインして行けるかが重要となるだろう。

最後に、AI技術を検討する場と多くの示唆を頂いた先端IT活用推進コンソーシアム(AITC)※12およびAITC TensorFlow研究会の皆さま、さまざまなAI研究会・勉強会で示唆を頂いた東京女子大学の浅川伸一先生※13に感謝の意を表したい。

- ※12 先端IT活用推進コンソーシアム。(http://aitc.jp/)

- ※13 Shin's Home Page.(http://www.cis.twcu.ac.jp/~asakawa/)